认识深度学习中的知识蒸馏

11页1、一分钟带你认识深度学习中的知识蒸馏 【摘要】 知识蒸馏(knowledge distillation)是模型压缩的一种常用的方法,不同于模型压缩中的剪枝和量化,知识蒸馏是通过构建一个轻量化的小模型,利用性能更好的大模型的监督信息,来训练这个小模型,以期达到更好的性能和精度。本文将深入浅出的介绍知识蒸馏的概念和原理,最后通过一个实际的上手案例,来指导用户使用知识蒸馏。一、知识蒸馏入门1.1 概念介绍知识蒸馏(knowledge distillation)是模型压缩的一种常用的方法,不同于模型压缩中的剪枝和量化,知识蒸馏是通过构建一个轻量化的小模型,利用性能更好的大模型的监督信息,来训练这个小模型,以期达到更好的性能和精度。最早是由Hinton在2015年首次提出并应用在分类任务上面,这个大模型我们称之为teacher(教师模型),小模型我们称之为Student(学生模型)。来自Teacher模型输出的监督信息称之为knowledge(知识),而student学习迁移来自teacher的监督信息的过程称之为Distillation(蒸馏)。1.2 知识蒸馏的种类图1 知识蒸馏的种类1、 离

2、线蒸馏 离线蒸馏方式即为传统的知识蒸馏,如上图(a)。用户需要在已知数据集上面提前训练好一个teacher模型,然后在对student模型进行训练的时候,利用所获取的teacher模型进行监督训练来达到蒸馏的目的,而且这个teacher的训练精度要比student模型精度要高,差值越大,蒸馏效果也就越明显。一般来讲,teacher的模型参数在蒸馏训练的过程中保持不变,达到训练student模型的目的。蒸馏的损失函数distillation loss计算teacher和student之前输出预测值的差别,和student的loss加在一起作为整个训练loss,来进行梯度更新,最终得到一个更高性能和精度的student模型。2、 半监督蒸馏 半监督方式的蒸馏利用了teacher模型的预测信息作为标签,来对student网络进行监督学习,如上图(b)。那么不同于传统离线蒸馏的方式,在对student模型训练之前,先输入部分的未标记的数据,利用teacher网络输出标签作为监督信息再输入到student网络中,来完成蒸馏过程,这样就可以使用更少标注量的数据集,达到提升模型精度的目的。3、 自监

3、督蒸馏 自监督蒸馏相比于传统的离线蒸馏的方式是不需要提前训练一个teacher网络模型,而是student网络本身的训练完成一个蒸馏过程,如上图(c)。具体实现方式 有多种,例如先开始训练student模型,在整个训练过程的最后几个epoch的时候,利用前面训练的student作为监督模型,在剩下的epoch中,对模型进行蒸馏。这样做的好处是不需要提前训练好teacher模型,就可以变训练边蒸馏,节省整个蒸馏过程的训练时间。1.3 知识蒸馏的功能1、提升模型精度 用户如果对目前的网络模型A的精度不是很满意,那么可以先训练一个更高精度的teacher模型B(通常参数量更多,时延更大),然后用这个训练好的teacher模型B对student模型A进行知识蒸馏,得到一个更高精度的模型。2、降低模型时延,压缩网络参数 用户如果对目前的网络模型A的时延不满意,可以先找到一个时延更低,参数量更小的模型B,通常来讲,这种模型精度也会比较低,然后通过训练一个更高精度的teacher模型C来对这个参数量小的模型B进行知识蒸馏,使得该模型B的精度接近最原始的模型A,从而达到降低时延的目的。3、图片标签之间

《认识深度学习中的知识蒸馏》由会员Baige****0346分享,可在线阅读,更多相关《认识深度学习中的知识蒸馏》请在金锄头文库上搜索。

员工积极主动行为的组态效应:基于过程的视角

汪晖齐物平等与跨体系社会的天下想象

函数性质中的数学抽象在问题解决与设计中的应用

日本东京大学入学考试理科数学试题解析

二次电池研究进展

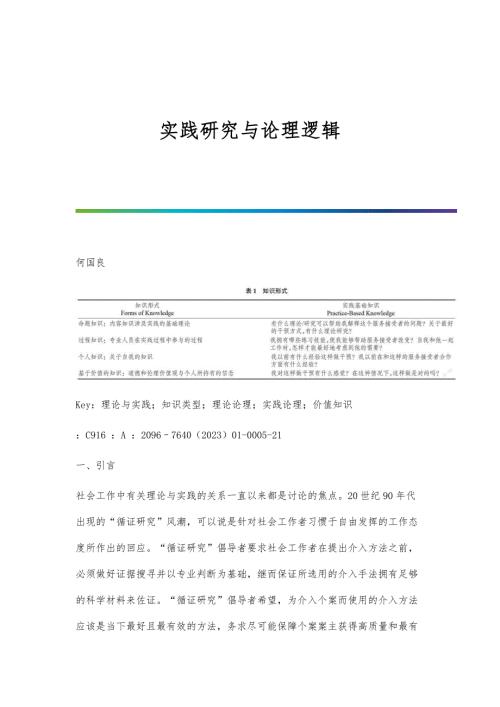

实践研究与论理逻辑

光学视觉传感器技术研究进展

龙泉青瓷的传承困境与发展

齐齐哈尔地区抗根肿病大白菜品种的抗性鉴定与评价

基于系统动力学模型的胶州湾海域承载力预测

基于弯液面电化学连接碳纤维实验初探

龟甲胶研究发展探析

鼻腔黏膜免疫佐剂鞭毛蛋白的研究进展

鼻内镜辅助上颌骨部分切除术治疗鼻腔鼻窦腺样囊性癌的临床分析

黑豆不同发芽期多酚、黄酮及抗氧化活性分析

齐鲁青未了:山东当代文学审美流变论

黄登水电站机电设备安装工程施工技术质量管理

黄河文化传承视角下音乐剧创作探究

黄亦琦从风论治咳嗽变异性哮喘经验※

鲸豚动物吸附式声学行为记录器综述

Kotlin设计模式实现之装饰者模式

Kotlin设计模式实现之装饰者模式

2022-03-24 12页

《信息安全系统设计基础》第三周学习总结

《信息安全系统设计基础》第三周学习总结

2022-03-24 11页

《信息安全系统设计基础》第四周学习总结

《信息安全系统设计基础》第四周学习总结

2022-03-24 10页

MVC思想及SpringMVC设计理念

MVC思想及SpringMVC设计理念

2022-03-24 25页

Jmeter接口测试数据库断言的实现与设计

Jmeter接口测试数据库断言的实现与设计

2022-03-24 13页

揭秘Spring类型转换-框架设计的基石

揭秘Spring类型转换-框架设计的基石

2022-03-24 18页

《信息安全系统设计基础》第1周学习总结

《信息安全系统设计基础》第1周学习总结

2022-03-24 10页

Kafka核心设计与实践原理总结-进阶篇

Kafka核心设计与实践原理总结-进阶篇

2022-03-24 32页

Activiti命令拦截器和设计模式

Activiti命令拦截器和设计模式

2022-03-24 8页

设计模式春招面试复习-命令模式

设计模式春招面试复习-命令模式

2022-03-24 9页