零基础入门深度学习-神经网络和反向传播算法

15页1、关闭 零基础入门深度学习(3) - 神经网络和反向传播算法 机器学习 深度学习入门 无论即将到来的是大数据时代还是人工智能时代,亦或是传统行业使用人工智能在云上处理大数据的时代,作为一个有理想有追 求的程序员,不懂深度学习(Deep Learning)这个超热的技术,会不会感觉马上就out了?现在救命稻草来了,零基础入门深 度学习系列文章旨在讲帮助爱编程的你从零基础达到入门级水平。零基础意味着你不需要太多的数学知识,只要会写程序就行 了,没错,这是专门为程序员写的文章。虽然文中会有很多公式你也许看不懂,但同时也会有更多的代码,程序员的你一定能看 懂的(我周围是一群狂热的Clean Code程序员,所以我写的代码也不会很差)。 文章列表 零基础入门深度学习(1) - 感知器 零基础入门深度学习(2) - 线性单元和梯度下降 零基础入门深度学习(3) - 神经网络和反向传播算法 零基础入门深度学习(4) - 卷积神经网络 零基础入门深度学习(5) - 循环神经网络 零基础入门深度学习(6) - 长短时记忆网络(LSTM) 零基础入门深度学习(7) - 递归神经网络 往期回顾 在上一篇文章中

2、,我们已经掌握了机器学习的基本套路,对模型、目标函数、优化算法这些概念有了一定程度的理解,而且已经会训练单个 的感知器或者线性单元了。在这篇文章中,我们将把这些单独的单元按照一定的规则相互连接在一起形成神经网络,从而奇迹般的获得了强 大的学习能力。我们还将介绍这种网络的训练算法:反向传播算法。最后,我们依然用代码实现一个神经网络。如果您能坚持到本文的结 尾,将会看到我们用自己实现的神经网络去识别手写数字。现在请做好准备,您即将双手触及到深度学习的大门。 神经元 神经元和感知器本质上是一样的,只不过我们说感知器的时候,它的激活函数是阶跃函数;而当我们说神经元时,激活函数往往选择为 sigmoid函数或tanh函数。如下图所示: 计算一个神经元的输出的方法和计算一个感知器的输出是一样的。假设神经元的输入是向量 ,权重向量是 (偏置项是),激活函数是 sigmoid函数,则其输出 : sigmoid函数的定义如下: 将其带入前面的式子,得到 sigmoid函数是一个非线性函数,值域是(0,1)。函数图像如下图所示 sigmoid函数的导数是: 可以看到,sigmoid函数的导数非常有趣,它可

3、以用sigmoid函数自身来表示。这样,一旦计算出sigmoid函数的值,计算它的导数的值就非常 方便。 神经网络是啥 神经网络其实就是按照一定规则连接起来的多个神经元。上图展示了一个全连接(full connected, FC)神经网络,通过观察上面的图, 我们可以发现它的规则包括: 神经元按照层来布局。最左边的层叫做输入层,负责接收输入数据;最右边的层叫输出层,我们可以从这层获取神经网络输出数据。 输入层和输出层之间的层叫做隐藏层,因为它们对于外部来说是不可见的。 同一层的神经元之间没有连接。 第N层的每个神经元和第N-1层的所有神经元相连(这就是full connected的含义),第N-1层神经元的输出就是第N层神经元的输入。 每个连接都有一个权值。 上面这些规则定义了全连接神经网络的结构。事实上还存在很多其它结构的神经网络,比如卷积神经网络(CNN)、循环神经网络(RNN),他们 都具有不同的连接规则。 计算神经网络的输出 神经网络实际上就是一个输入向量 到输出向量 的函数,即: 根据输入计算神经网络的输出,需要首先将输入向量 的每个元素的值赋给神经网络的输入层的对应神经元,

4、然后根据式1依次向前计算每 一层的每个神经元的值,直到最后一层输出层的所有神经元的值计算完毕。最后,将输出层每个神经元的值串在一起就得到了输出向量 。 接下来举一个例子来说明这个过程,我们先给神经网络的每个单元写上编号。 式 令 则 如上图,输入层有三个节点,我们将其依次编号为1、2、3;隐藏层的4个节点,编号依次为4、5、6、7;最后输出层的两个节点编号为8、 9。因为我们这个神经网络是全连接网络,所以可以看到每个节点都和上一层的所有节点有连接。比如,我们可以看到隐藏层的节点4,它 和输入层的三个节点1、2、3之间都有连接,其连接上的权重分别为。那么,我们怎样计算节点4的输出值呢? 为了计算节点4的输出值,我们必须先得到其所有上游节点(也就是节点1、2、3)的输出值。节点1、2、3是输入层的节点,所以,他们的 输出值就是输入向量 本身。按照上图画出的对应关系,可以看到节点1、2、3的输出值分别是。我们要求输入向量的维度和输入 层神经元个数相同,而输入向量的某个元素对应到哪个输入节点是可以自由决定的,你偏非要把赋值给节点2也是完全没有问题的,但这 样除了把自己弄晕之外,并没有什么价值。

《零基础入门深度学习-神经网络和反向传播算法》由会员第***分享,可在线阅读,更多相关《零基础入门深度学习-神经网络和反向传播算法》请在金锄头文库上搜索。

校园足球汇报

异甘草酸镁注射液【治疗急性药物性肝损伤】Ⅱ期临床研究总结

云教室课程行政伦理学行政良心

语文S版小学二年级语文下册诺亚方舟课件优质课教学课件

未来中考趋势作文考与练

近年来广东历史试题中考易错点分析与教学启示

搜索推广那些事

小学语文二年级上册红领巾真好说课稿设计(说课设计)

新课标人教版二年级语文上册红领巾真好课件

新课程背景下的高中化学课堂教学改革

危机管理与突发事件应对

背影朱自清教案课件二课时

突发公共卫生事件培训

统计学简史及数据科学中南财经大学

水泥混凝土路面技术现状及发展终

有家真好作文讲评课

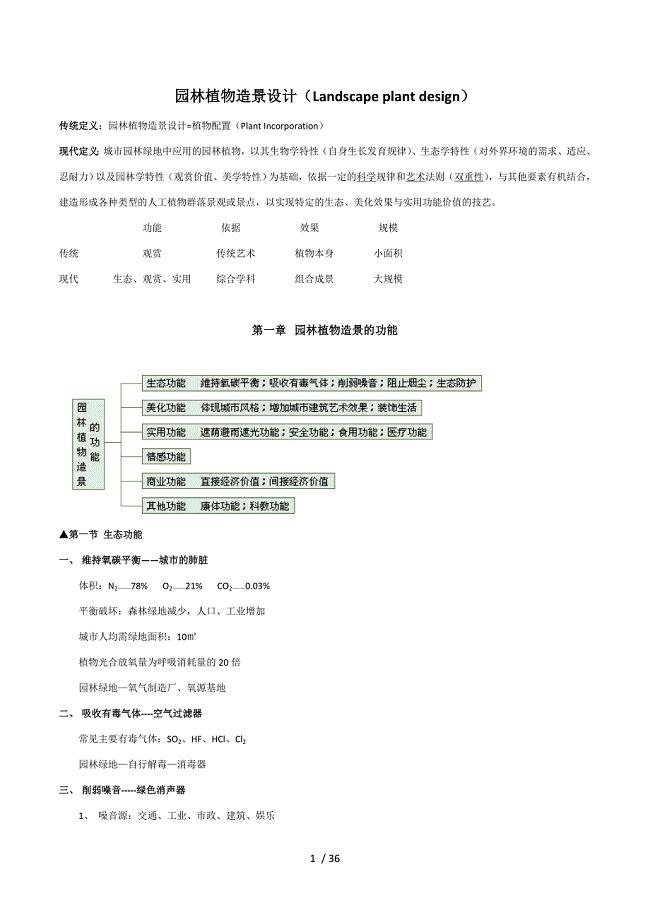

西南大学植物造景设计总复习

海外汉语教学新探索在线交流学习平台Goclef

动态黑色背景年终总结模板

孙子的治军之道与现代管理谋略总结

大学计算机基础知识点总结(30页)

大学计算机基础知识点总结(30页)

2024-04-25 30页

大学科目《普通地质学》课后思考

大学科目《普通地质学》课后思考

2024-04-25 22页

《学生手册》考题(含参考答案)

《学生手册》考题(含参考答案)

2024-04-25 7页

大学科目《采煤概论》复习资料

大学科目《采煤概论》复习资料

2024-04-25 5页

大一计算机基础知识试题及答案

大一计算机基础知识试题及答案

2024-04-25 8页

2021年12月大学英语4级CET4听力原文(卷二)

2021年12月大学英语4级CET4听力原文(卷二)

2024-04-23 5页

2021年12月大学英语6级CET6听力原文(卷一)

2021年12月大学英语6级CET6听力原文(卷一)

2024-04-23 23页

大学科目《计量经济学》期末试题和答案

大学科目《计量经济学》期末试题和答案

2024-04-23 6页

2021年12月大学英语4级CET4听力原文(卷一)

2021年12月大学英语4级CET4听力原文(卷一)

2024-04-23 5页

2021年12月大学英语6级CET6听力原文(卷二)

2021年12月大学英语6级CET6听力原文(卷二)

2024-04-23 10页