基于深度强化学习的驾驶仪参数快速整定方法

17页1、 基于深度强化学习的驾驶仪参数快速整定方法 万齐天,卢宝刚,赵雅心,温求遒,*(1.北京理工大学宇航学院,北京 100081;2.北京航天长征飞行器研究所,北京 100076;3.中国运载火箭技术研究院,北京 100076)0 引 言自动驾驶仪的主要任务为控制和稳定飞行器飞行,消除干扰引起的飞行器姿态变化,使飞行器按照期望的飞行轨迹或飞行姿态飞行1。作为一种经典的过载驾驶仪设计结构,三回路驾驶仪以其良好的性能在飞行器控制领域得到了广泛的应用。三回路驾驶仪的设计过程中需对二阶根自振频率的进行设计,文献2-5采用求解关于稳定裕度的非线性方程来得到合适的二阶根自振频率。然而,传统驾驶仪设计方法采用非全局剖面状态进行控制参数设计,导致其对全局约束和性能指标的考量不足。当飞行环境存在较大的不确定性时,会导致飞行器对标称轨迹跟踪制导方式的自主性和鲁棒性较差。近年来,深度强化学习方法的发展6-9为飞行器智能控制实现提供了新的可能。强化学习10-13是一种基于动态规划求解框架的无模型马尔可夫决策过程(Markov decision process,MDP)处理方法,通过智能体与环境的不断交互和迭代学习

2、,找到可以让智能体获取最大收益的最优策略。深度强化学习的弱模型特性和可迁移性相比于传统控制优化方法具有更广泛的适用性,在飞行器控制系统设计中有着良好的应用前景。目前,深度强化学习方法在智能控制领域已取得一定研究成果14-23。文献24利用反向传播神经网络算法作为值函数的逼近策略,对舵机动作池进行了离散处理并训练得到控制策略。文献25利用强化学习及自适应动态规划原理,设计了一种适用于微小型弹药的两回路驾驶仪,并建立了纵向通道控制模型。文献26提出了一种基于深度强化学习的智能比例-积分-微分(proportional-integral-differential,PID)控制器,实现了对过载指令的精确跟踪。但目前采用深度强化学习的控制设计方法存在训练参数维数过大、策略学习效率不高、算法不易收敛等问题,如何提升深度强化学习方法在飞行器驾驶仪领域的实用性成为了亟待解决的问题。本文提出一种基于深度强化学习的三回路驾驶仪参数自整定方法,采用近端策略优化算法,针对驾驶仪控制参数设计造成的训练速度慢、奖励函数收敛性不好等问题进行优化改进。通过解析法得到从三维控制变量转换为一维设计参量的关系式,对深度强化

3、学习训练数据的维度进行了简化,提高了算法的效率和奖励函数收敛性。本文内容安排如下:第1部分提出了以驾驶仪极点配置为核心的控制参数快速设计方法;第2部分构建了离线深度强化学习训练叠加在线多层感知器神经网络实时计算的智能控制架构;第3部分以典型再入飞行器为例,完成深度强化学习训练和神经网络部署,并进行了仿真验证。1 控制参数快速设计方法如图1所示,当前很多飞行器上采用了三回路驾驶仪结构,可采用极点配置法对其设计控制参数。各动力学参量定义可Reference27。图1 驾驶仪结构图Fig.1 Diagram of autopilot structure三回路驾驶仪主导极点为一负实根,由时间常数决定,直接决定了系统响应的主要特性。非主导极点由一对振荡根组成,并可由自振频率与阻尼表示。这两个参数中,阻尼决定了二阶系统振荡特性,为保证系统好的动态特性,通常设计中期望其值在0.7左右。而二阶根自振频率则往往很难提出绝对合理的设计约束。略去舵机、角速度陀螺、结构滤波器及过载计的动态特性,将系统在舵机所处位置断开,得到系统开环传递函数为待设计的控制变量有k g、i、k ac,可根据三回路驾驶仪设计经验对

4、设计参数进行简化。根据文献2推导可得驾驶仪设计参数k g,i,k ac的设计表达式为各动力学参量定义可Reference27,计算所需各变量值为由此可将驾驶仪控制变量k g、i、k ac的设计转化为设计参量、的设计。通常给定为0.7,由驾驶仪快速性确定,而在设计中很难确定。通过已有文献证明2,的变化对相位裕度P m和幅值裕度G m具有明显影响。可通过求解关于稳定裕度P m的非线性方程,使稳定裕度不断接近理想设计指标,最终完成自振频率的迭代求解。由此可得到将三维控制参数设计转化为一维设计参量设计的快速设计方法。2 基于深度强化学习的驾驶仪参数自整定方法以第1节推导的控制参数快速设计方法为基础,构建面向飞行器全飞行包络范围的近端策略优化(proximal policy optimization,PPO)离线训练方法,使得可以快速完成对设计参量在线调节的多层感知器(multi-layer perception,MLP)神经网络的训练。将训练完成的MLP神经网络进行在线部署,根据当前实际的飞行状态,由MLP神经网络实时计算得到设计参量,并直接调用快速设计方法中的极点配置解析计算方程,从而快速完

《基于深度强化学习的驾驶仪参数快速整定方法》由会员杨***分享,可在线阅读,更多相关《基于深度强化学习的驾驶仪参数快速整定方法》请在金锄头文库上搜索。

员工积极主动行为的组态效应:基于过程的视角

汪晖齐物平等与跨体系社会的天下想象

函数性质中的数学抽象在问题解决与设计中的应用

日本东京大学入学考试理科数学试题解析

二次电池研究进展

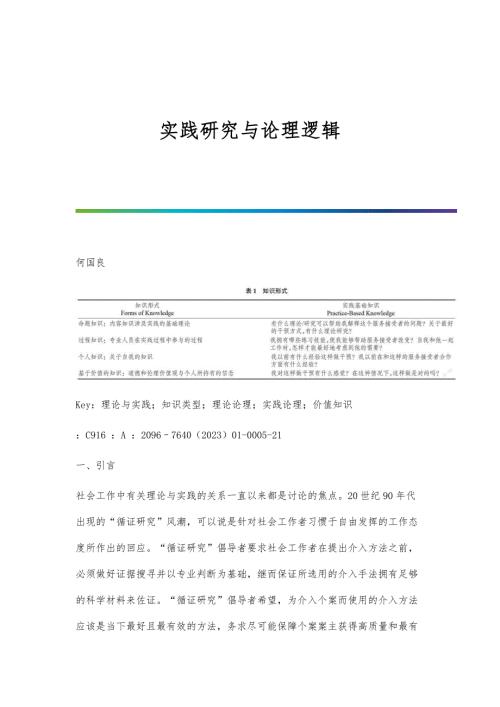

实践研究与论理逻辑

光学视觉传感器技术研究进展

龙泉青瓷的传承困境与发展

齐齐哈尔地区抗根肿病大白菜品种的抗性鉴定与评价

基于系统动力学模型的胶州湾海域承载力预测

基于弯液面电化学连接碳纤维实验初探

龟甲胶研究发展探析

鼻腔黏膜免疫佐剂鞭毛蛋白的研究进展

鼻内镜辅助上颌骨部分切除术治疗鼻腔鼻窦腺样囊性癌的临床分析

黑豆不同发芽期多酚、黄酮及抗氧化活性分析

齐鲁青未了:山东当代文学审美流变论

黄登水电站机电设备安装工程施工技术质量管理

黄河文化传承视角下音乐剧创作探究

黄亦琦从风论治咳嗽变异性哮喘经验※

鲸豚动物吸附式声学行为记录器综述

短肠综合征的营养支持新方法

短肠综合征的营养支持新方法

2024-05-10 22页

睾丸癌的纳米药物靶向递送系统研究

睾丸癌的纳米药物靶向递送系统研究

2024-05-10 20页

睾丸癌的病理类型与预后因素

睾丸癌的病理类型与预后因素

2024-05-10 19页

睾丸素在衰老过程中的作用

睾丸素在衰老过程中的作用

2024-05-10 20页

睑裂畸形的胚胎学发育与遗传学研究

睑裂畸形的胚胎学发育与遗传学研究

2024-05-10 24页

砍创类武器损伤痕迹规律

砍创类武器损伤痕迹规律

2024-05-10 24页

睑裂畸形的康复训练与长期随访

睑裂畸形的康复训练与长期随访

2024-05-10 23页

睾丸扭转坏死后睾丸间质细胞的功能变化

睾丸扭转坏死后睾丸间质细胞的功能变化

2024-05-10 21页

知识传递中经验和权威的平衡

知识传递中经验和权威的平衡

2024-05-10 22页

砍创类武器痕迹绘制技术

砍创类武器痕迹绘制技术

2024-05-10 24页