分布式数据库HBase

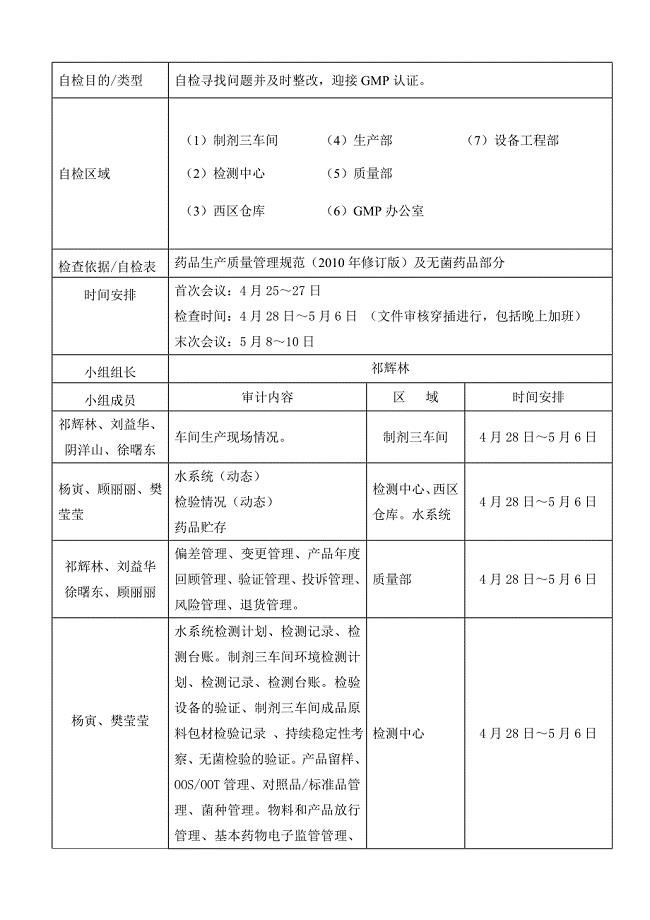

7页1、HBase概念HBase Hadoop Database,是一个高可靠性、高性能、面向列、可伸缩的分布式存储系统,利用HBase技术可在廉价PC Server上搭建起大规模结构化存储集群。HBase是Google Bigtable的开源实现,类似Google Bigtable利用GFS作为其文件存储系统,HBase利用Hadoop HDFS作为其文件存储系统;Google运行MapReduce来处理Bigtable中的海量数据,HBase同样利用Hadoop MapReduce来处理HBase中的海量数据;Google Bigtable利用 Chubby作为协同服务,HBase利用Zookeeper作为对应。上图描述了Hadoop EcoSystem中的各层系统,其中HBase位于结构化存储层,Hadoop HDFS为HBase提供了高可靠性的底层存储支持,Hadoop MapReduce为HBase提供了高性能的计算能力,Zookeeper为HBase提供了稳定服务和failover机制。此外,Pig和Hive还为HBase提供了高层语言支持,使得在HBase上进行数据统计处理变的非

2、常简单。 Sqoop则为HBase提供了方便的RDBMS数据导入功能,使得传统数据库数据向HBase中迁移变的非常方便。HBase访问接口1. Native Java API,最常规和高效的访问方式,适合Hadoop MapReduce Job并行批处理HBase表数据2. HBase Shell,HBase的命令行工具,最简单的接口,适合HBase管理使用3. Thrift Gateway,利用Thrift序列化技术,支持C+,PHP,Python等多种语言,适合其他异构系统在线访问HBase表数据4. REST Gateway,支持REST 风格的Http API访问HBase, 解除了语言限制5. Pig,可以使用Pig Latin流式编程语言来操作HBase中的数据,和Hive类似,本质最终也是编译成MapReduce Job来处理HBase表数据,适合做数据统计6. Hive,当前Hive的Release版本尚没有加入对HBase的支持,但在下一个版本Hive 0.7.0中将会支持HBase,可以使用类似SQL语言来访问HBaseHBase数据模型Table & Column

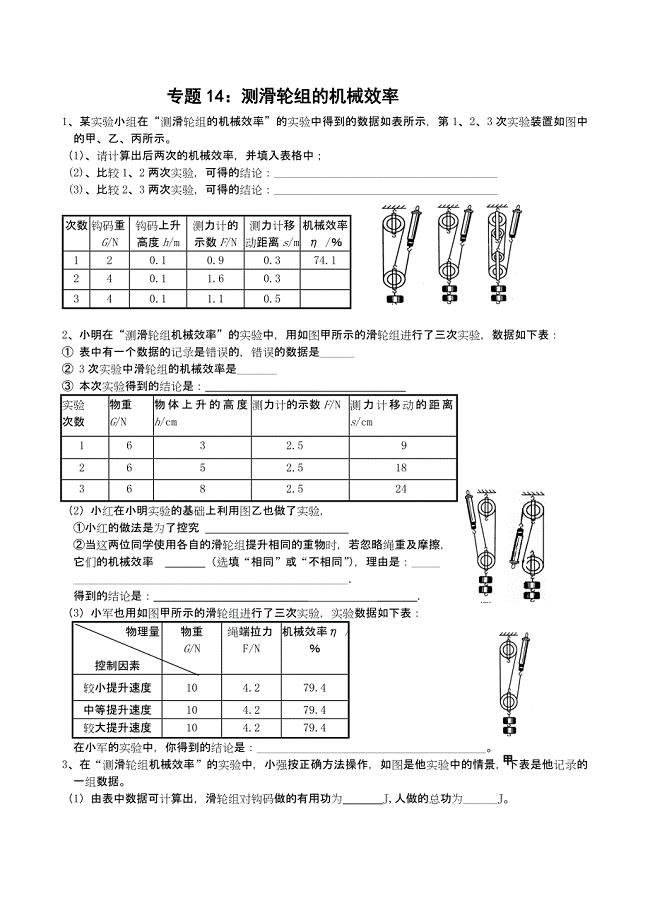

3、 FamilyRow KeyTimestampColumn FamilyURIParserr1t3title=天天特价t2host=t1r2t5content=每天t4host=Row Key: 行键,Table的主键,Table中的记录按照Row Key排序Timestamp: 时间戳,每次数据操作对应的时间戳,可以看作是数据的version numberColumn Family:列簇,Table在水平方向有一个或者多个Column Family组成,一个Column Family中可以由任意多个Column组成,即Column Family支持动态扩展,无需预先定义Column的数量以及类型,所有Column均以二进制格式存储,用户需要自行进行类型转换。Table & Region当Table随着记录数不断增加而变大后,会逐渐分裂成多份splits,成为regions,一个region由startkey,endkey)表示,不同的region会被Master分配给相应的RegionServer进行管理:-ROOT- & .META. TableHBase中有两张特殊的Table,

4、-ROOT-和.META. .META.:记录了用户表的Region信息,.META.可以有多个regoin -ROOT-:记录了.META.表的Region信息,-ROOT-只有一个region Zookeeper中记录了-ROOT-表的locationClient访问用户数据之前需要首先访问zookeeper,然后访问-ROOT-表,接着访问.META.表,最后才能找到用户数据的位置去访问,中间需要多次网络操作,不过client端会做cache缓存。MapReduce on HBase在HBase系统上运行批处理运算,最方便和实用的模型依然是MapReduce,如下图:HBase Table和Region的关系,比较类似HDFS File和Block的关系,HBase提供了配套的TableInputFormat和TableOutputFormat API,可以方便的将HBase Table作为Hadoop MapReduce的Source和Sink,对于MapReduce Job应用开发人员来说,基本不需要关注HBase系统自身的细节。HBase系统架构ClientHBase Cl

《分布式数据库HBase》由会员公****分享,可在线阅读,更多相关《分布式数据库HBase》请在金锄头文库上搜索。

电子硬盘(DOM盘)和固态硬盘(SSD盘)

电子硬盘(DOM盘)和固态硬盘(SSD盘)

2023-03-28 2页

机械原理第一次作业

机械原理第一次作业

2024-02-15 3页

无线传感器网络研究现状与应用

无线传感器网络研究现状与应用

2023-06-15 5页

欧盟ERP能效要求-增加网络待机功率要求

欧盟ERP能效要求-增加网络待机功率要求

2022-10-30 3页

循环水浓缩倍率提高系统终稿

循环水浓缩倍率提高系统终稿

2022-11-19 7页

机械运动基础知识复习

机械运动基础知识复习

2023-07-04 3页

给水用UPVC管道系统的连接方式

给水用UPVC管道系统的连接方式

2023-09-07 2页

ASPEN详细算例之《化工过程数学模型与计算机模拟》

ASPEN详细算例之《化工过程数学模型与计算机模拟》

2023-12-15 26页

万能型电视遥控器代码表

万能型电视遥控器代码表

2022-11-29 17页

计算机控制系统原理框图

计算机控制系统原理框图

2023-07-31 8页