[全]做数据分析必会的5个SQL数据清洗方法

6页1、做数据分析必会的5个SQL数据清洗方法大纲如图:删除指定列、重命名列场景:多数情况并不是底表的所有特征(列)都对分析有用,这个时候就只需要抽取部分列,对于不用的那些列,可以删除。重命名列可以避免有些列的命名过于冗长(比如Case When 语句),且有时候会根据不同的业务指标需求来命名。删除列Python版:df.drop(col_names,axis=1,inplace=True)删除列SQL版:1、selectcol_namesfromTable_Name2、altertabletableNamedropcolumncolumnName重命名列Python版:df.rename(index=row1:A,columns=col1:B)重命名列SQL版:selectcol_namesascol_name_BfromTable_Name因为一般情况下是没有删除的权限(可以构建临时表),反向思考,删除的另一个逻辑是选定指定列(Select)。重复值、缺失值处理场景:比如某网站今天来了1000个人访问,但一个人一天中可以访问多次,那数据库中会记录用户访问的多条记录,而这时候如果想要找到今天

2、访问这个网站的1000个人的ID并根据此做用户调研,需要去掉重复值给业务方去回访。缺失值:NULL做运算逻辑时,返回的结果还是NULL,这可能就会出现一些脚本运行正确,但结果不对的BUG,此时需要将NULL值填充为指定值。重复值处理Python版:df.drop_duplicates()重复值处理SQL版:1、selectdistinctcol_namefromTable_Name2、selectcol_namefromTable_Namegroupbycol_name缺失值处理Python版:df.fillna(value=0)bine_first(df2)缺失值处理SQL版:1、selectifnull(col_name,0)valuefromTable_Name2、selectcoalesce(col_name,col_name_A,0)asvaluefromTable_Name3、selectcasewhencol_nameisnullthen0elsecol_nameendfromTable_Name替换字符串空格、清洗*%等垃圾字符、字符串拼接、分隔等字符串处理场景:理解用

《[全]做数据分析必会的5个SQL数据清洗方法》由会员赵****分享,可在线阅读,更多相关《[全]做数据分析必会的5个SQL数据清洗方法》请在金锄头文库上搜索。

2024二建市政在线考核题库含答案全套

2024年5月河北考面试题及参考答案全套

2024年5月6日下午河北省考面试题及参考答案全套

2024年5月河北邯郸选调生面试题及参考答案全套

2024年5月青海省选调生面试题及参考答案全套

2024年4月山东省青岛市事业单位面试题及参考答案全套

2024年5月海南省考公务员面试题及参考答案全套

2024年建筑升降机考前押题卷含答案全套

数学知识 一次函数4类常见易错题专项训练全套

2024版海南建筑安全生产管理三类人员考试考前押题全套

2024年浙江省工程监理在线测试模拟题库全套

2024年中级注册安全工程师考试之近年真题、参考答案、详细解释全套

2024年陕西三类人员c类题库全套

冲刺2024中级注安师考试之历年真题、真题改编、参考答案全套

高考语文 古诗鉴赏语言风格题型专练全套

2024年中级安全工程师考试之历年真题及真题改编 附参考答案全套

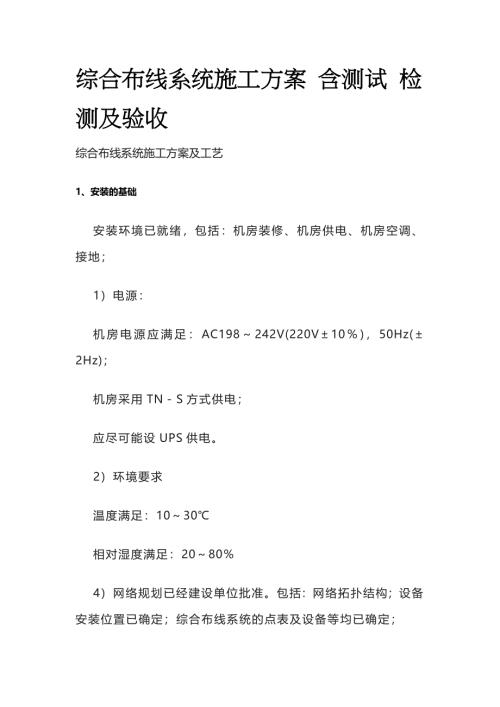

综合布线系统施工方案 含测试 检测及验收全套

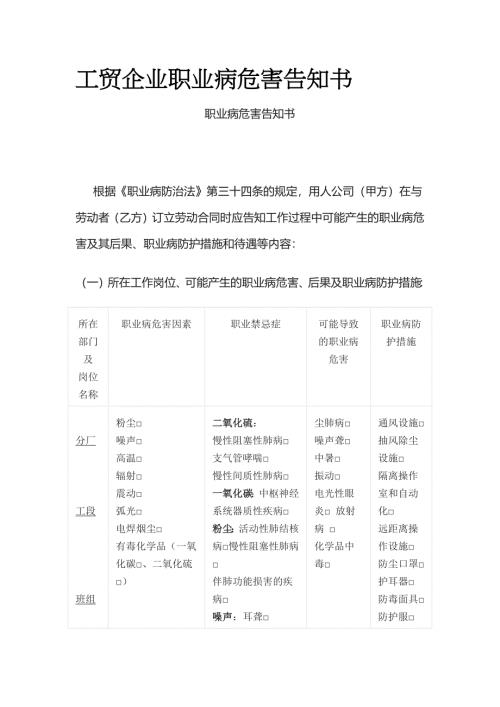

工贸企业职业病危害告知书全套

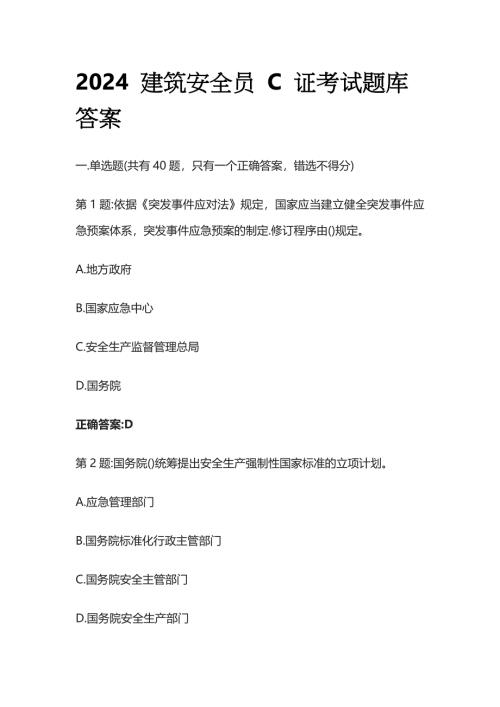

2024 建筑安全员 C 证考试题库答案全套

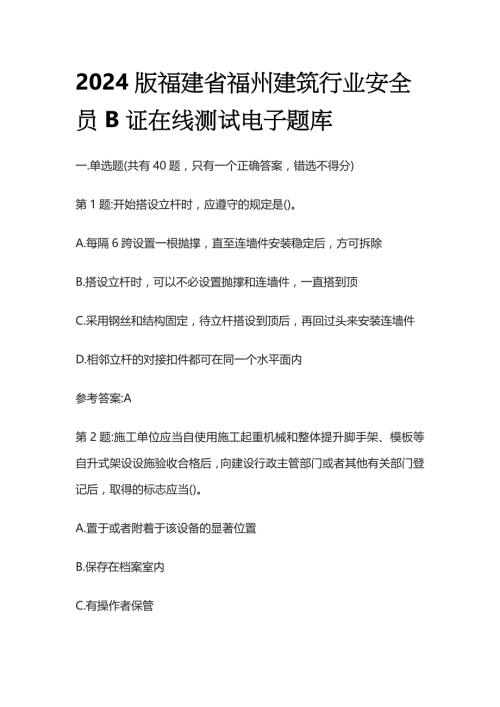

2024版福建省福州建筑行业安全员B证在线测试电子题库全套

南开大学《计算机组成原理》笔记-随堂笔记

南开大学《计算机组成原理》笔记-随堂笔记

2023-09-25 37页

北京林业大学《计算机组成原理》笔记-总结期末复习资料

北京林业大学《计算机组成原理》笔记-总结期末复习资料

2023-09-25 10页

《计算机网络》笔记-各章汇总

《计算机网络》笔记-各章汇总

2023-09-25 33页

《数据结构》笔记-期末复习知识点

《数据结构》笔记-期末复习知识点

2023-09-25 26页

盘点那些高逼格的sql写法

盘点那些高逼格的sql写法

2023-04-03 8页

全程干货:新手小白快速入门sql教程SQL基本书写规则

全程干货:新手小白快速入门sql教程SQL基本书写规则

2023-04-03 4页

经典常用SQL 基础知识数据库与 SQL

经典常用SQL 基础知识数据库与 SQL

2023-04-03 8页

2022年CSP-S第二轮C++真题源码解析1

2022年CSP-S第二轮C++真题源码解析1

2023-03-29 10页

2022年CSP-J第二轮C++真题源码解析2

2022年CSP-J第二轮C++真题源码解析2

2023-03-22 10页

2022年CSP-J第二轮C++真题源码解析1

2022年CSP-J第二轮C++真题源码解析1

2023-03-20 8页