支持向量机(五)smo算法 - jerrylead - 博客园

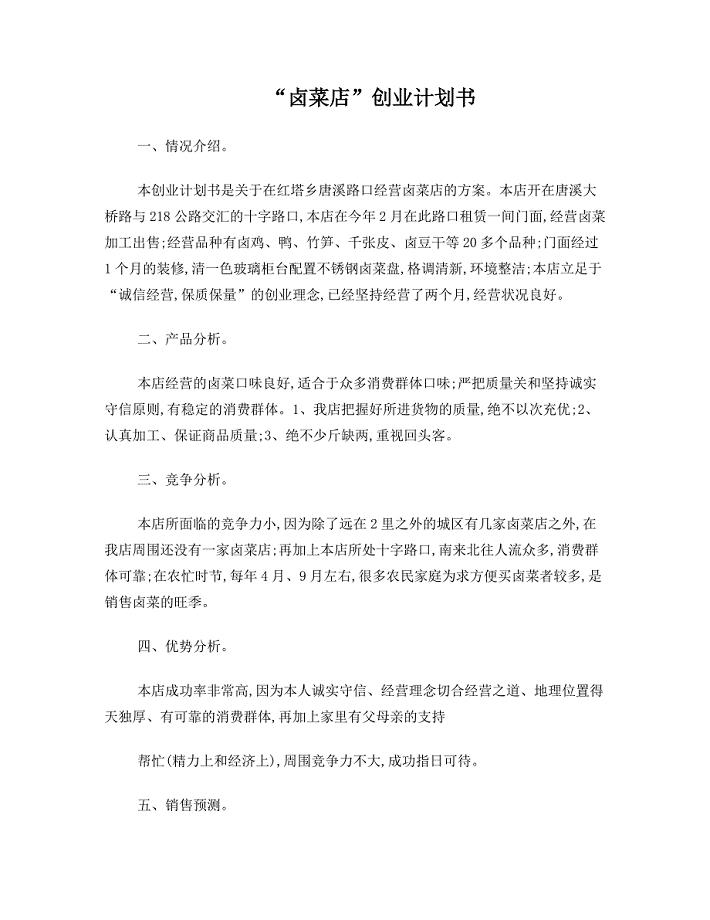

9页1、15-12-11支持向量机(五)SMO算法 - JerryLead - 博客园 支持向量机(五)SMO算法 11 SMO优化算法(Sequential minimal optimization) SMO算法由Microsoft Research的John C. Platt在1998年提出,并成为最快的二次规划优化算法,特别针对线 性SVM和数据稀疏时性能更优。关于SMO最好的资料就是他本人写的Sequential Minimal Optimization A Fast Algorithm for Training Support Vector Machines了。 我拜读了一下,下面先说讲义上对此方法的总结。 首先回到我们前面一直悬而未解的问题,对偶函数最后的优化问题: 要解决的是在参数上求最大值W的问题,至于和都是已知数。C由我们预先设定,也是已知 数。 按照坐标上升的思路,我们首先固定除以外的所有参数,然后在上求极值。等一下,这个思路有问题,因为如 果固定以外的所有参数,那么将不再是变量(可以由其他值推出),因为问题中规定了 因此,我们需要一次选取两个参数做优化,比如和,此时可以

2、由和其他参数表示出来。这样回带到W 中,W就只是关于的函数了,可解。 这样,SMO的主要步骤如下: 意思是,第一步选取一对和,选取方法使用启发式方法(后面讲)。第二步,固定除和之外的其他参数, 确定W极值条件下的,由表示。 SMO之所以高效就是因为在固定其他参数后,对一个参数优化过程很高效。 下面讨论具体方法: 假设我们选取了初始值满足了问题中的约束条件。接下来,我们固定,这样W就是 和的函数。并且和满足条件: 由于都是已知固定值,因此为了方面,可将等式右边标记成实数值 。 公告 Contact me via 昵称:JerryLead 园龄:4年9个月 粉丝:1468 关注:4 +加关注 导航 博客园 首页 新随笔 联系 订阅 管理 日一二三四五六 272812345 6789101112 13141516171819 20212223242526 272829303112 3456789 统计 随笔 - 27 文章 - 0 评论 - 351 引用 - 0 搜索 找找看 谷歌搜索 常用链接 我的随笔 我的评论 我的参与 最新评论 我的标签 我的标签 Machine Learning(2

3、2) Big Data(3) Maths(1) 随笔档案(27) 2013年4月 (1) 2012年8月 (2) 2012年5月 (1) 2011年8月 (1) 2011年6月 (1) 2011年5月 (2) 2011年4月 (10) 2011年3月 (9) JerryLead All things are difficult before they are easy. 15-12-11支持向量机(五)SMO算法 - JerryLead - 博客园 当和异号时,也就是一个为1,一个为-1时,他们可以表示成一条直线,斜率为1。如下图: 横轴是,纵轴是,和既要在矩形方框内,也要在直线上,因此 , 同理,当和同号时, , 然后我们打算将用表示: 然后反代入W中,得 展开后W可以表示成。其中a,b,c是固定值。这样,通过对W进行求导可以得到,然而要保证 满足,我们使用表示求导求出来的,然而最后的,要根据下面情况得到: 这样得到后,我们可以得到的新值。 下面进入Platt的文章,来找到启发式搜索的方法和求b值的公式。 这边文章使用的符号表示有点不太一样,不过实质是一样的,先来熟悉一下文章中符号

4、的表示。 文章中定义特征到结果的输出函数为 与我们之前的实质是一致的。 原始的优化问题为: 求导得到: 经过对偶后为: 积分与排名 积分 - 27628 排名 - 7638 最新评论 1. Re:小谈导数、梯度和极值 giveme5为什么=6?. -midu 2. Re:线性判别分析(Linear Discriminant Analysis)(一) xzf125244170这里(lamba_w 是新引入的一个常数). -邊城浪子 3. Re:Hadoop vs Spark性能对比 Spark本身就是对迭代计算有优势的。 -四通大哥 4. Re:PDF版学习笔记 感谢:) -drsalar 5. Re:PDF版学习笔记 为什么没法下载啊? -独步苍穹 阅读排行榜 1. Spark安装与学习(117261) 2. (EM算法)The EM Algorithm(114611) 3. 支持向量机SVM(一)(102104) 4. K-means聚类算法(100471) 5. 对线性回归,logistic回归和一般回 归的认识(63705) 评论排行榜 1. (EM算法)The EM Algor

《支持向量机(五)smo算法 - jerrylead - 博客园》由会员小**分享,可在线阅读,更多相关《支持向量机(五)smo算法 - jerrylead - 博客园》请在金锄头文库上搜索。

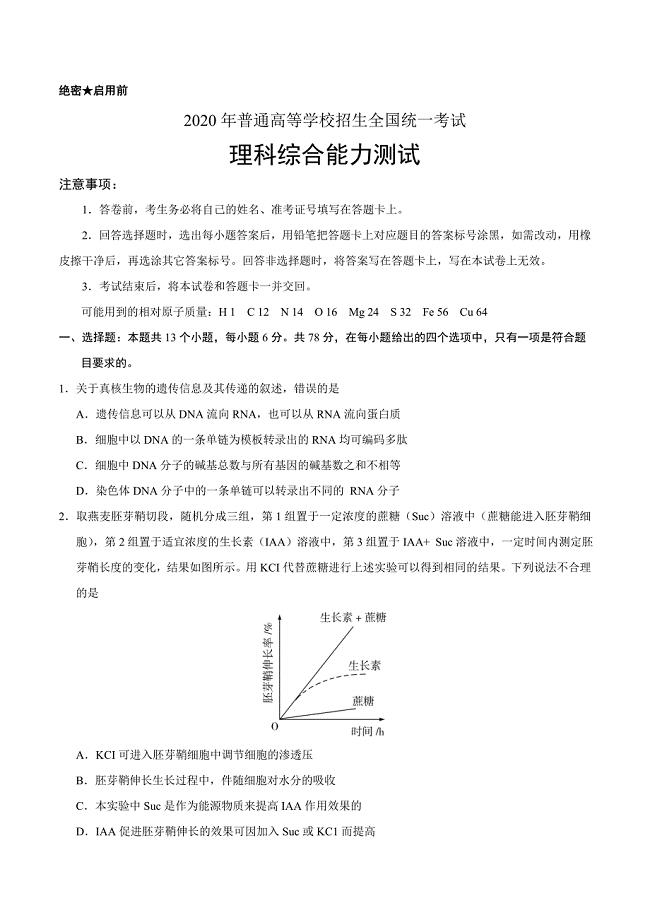

2020年高考真题——理科综合(全国卷Ⅲ)+Word版含答案

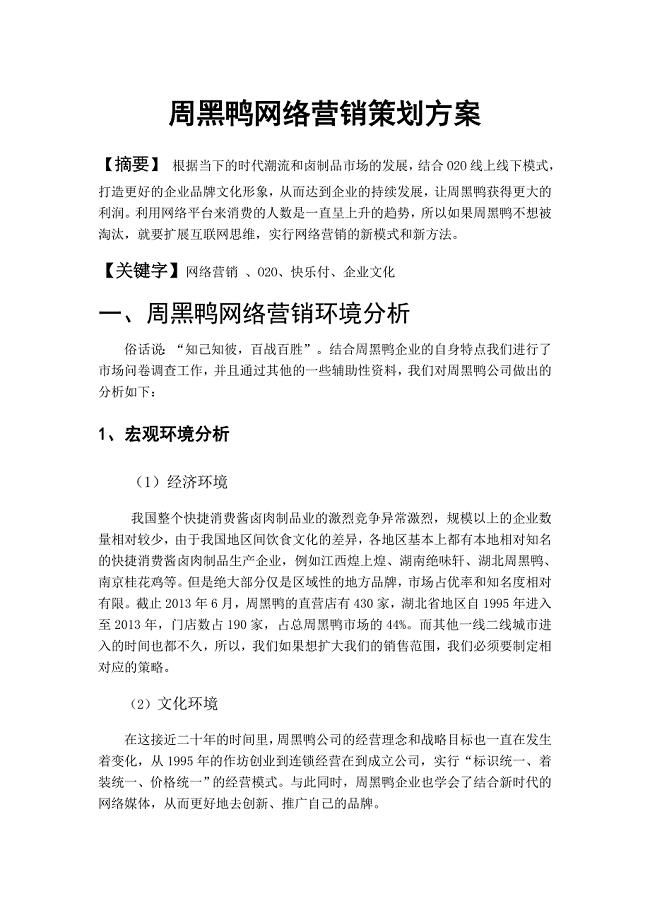

2021年绝味鸭脖策划书

2021年熟食店创业方案

2021年熟食店开店策划

2021年卤菜店创业计划书

2021年周黑鸭网络营销策划方案

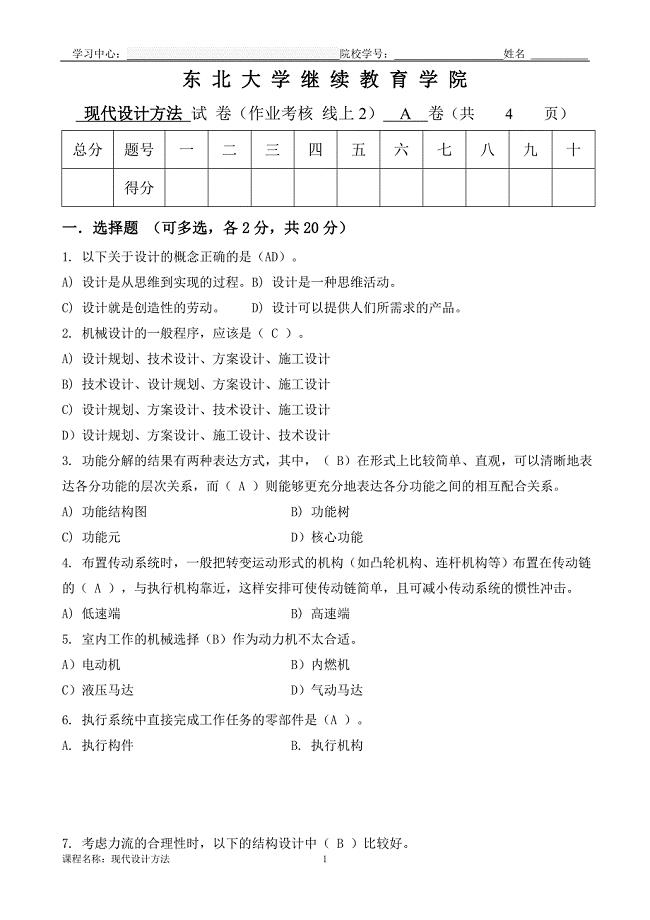

东大21年1月考试《现代设计方法》考核作业

谈我国行政管理效率的现状及其改观对策(论文)

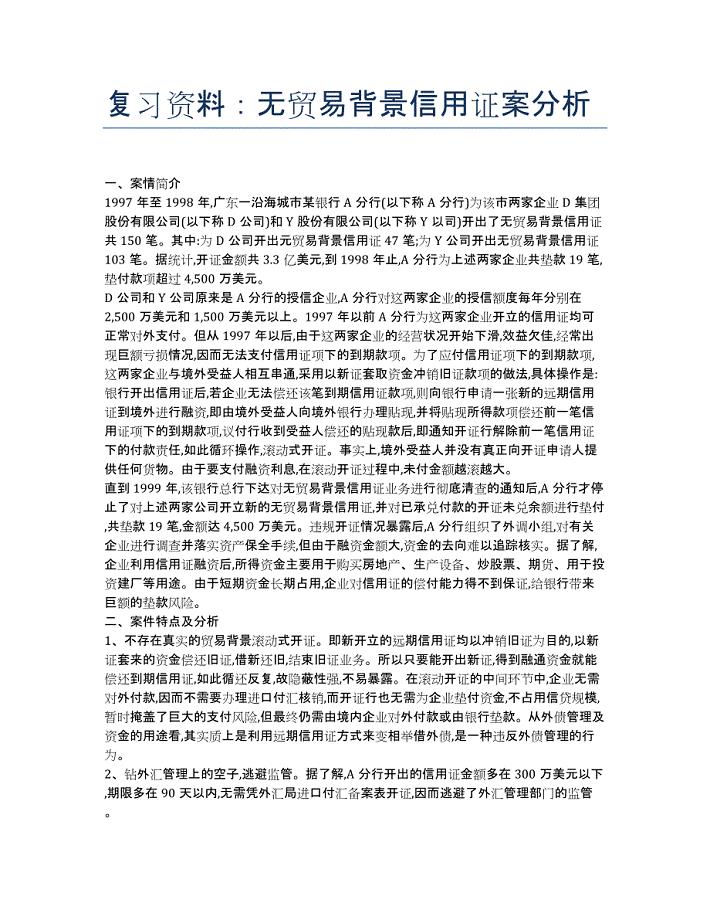

单证员考试-备考辅导-复习资料:无贸易背景信用证案分析.docx

土木工程毕业生答辩自述.docx

建筑学毕业后工作状态真实写照.doc

C#代码规范(湖南大学).doc

xx区食药监局2019年工作总结及2020年工作计划

2019年中医院药物维持治疗门诊工人先锋号先进事迹

2019年度xx乡镇林长制工作总结

2019年性艾科工作计划书

2019年人才服务局全国扶贫日活动开展情况总结

关于组工信息选题的几点思考

摘了穷帽子 有了新模样

2019年某集团公司基层党支部书记培训班心得体会

09.石油公司制度体系诊断及优化咨询项目

09.石油公司制度体系诊断及优化咨询项目

2024-04-08 33页

职工教育培训经费管理办法(规模生产制造业版)

职工教育培训经费管理办法(规模生产制造业版)

2024-04-08 10页

08.圆通银行战略咨询项目

08.圆通银行战略咨询项目

2024-04-08 25页

企业培训费管理实施暂行细则

企业培训费管理实施暂行细则

2024-04-08 12页

职工教育培训经费管理办法(适合中小企业)

职工教育培训经费管理办法(适合中小企业)

2024-04-08 10页

企业规章制度框架体系管理规定(2024修订版)

企业规章制度框架体系管理规定(2024修订版)

2024-04-08 21页

05.景宏集团全面管理提升咨询项目

05.景宏集团全面管理提升咨询项目

2024-04-08 40页

07.玉兔食品集团供应链咨询项目

07.玉兔食品集团供应链咨询项目

2024-04-08 34页

04.大华乳业业务战略咨询项目

04.大华乳业业务战略咨询项目

2024-04-08 28页

06.德邦公司精益生产管理咨询项目

06.德邦公司精益生产管理咨询项目

2024-04-08 28页