林天宇用python3学习编写网络爬虫(之一)

18页1、林天宇用Python3学习编写网络爬虫(之一:入门实践)作者:林天宇一、写在前面1、本文适应的读者范围l 会一点点Python的基本语法;l 已经安装好了Python3和PyCharm;l 网络爬虫新手2、本文所使用的开发环境l Mac pro / iOSl Python3l PyCharm3、本文不纠结以下内容l 为什么选择Python3而不是Python2?答:没什么特别原因,个人喜好。l 如何安装Pyhon3?请查阅其他文档。l PyCharm是什么?为什么不用其他工具。一个常用的Python开发工具,个人喜欢,可参阅其他文档。如果你不喜欢,你也可以用其他工具编码和调试。二、快速开始东北人有句话说:能动手,尽量不瞎叨叨。少些废话,快速开干。1、新建项目和文件启动PyCharm,“Create New Project”。因为估计不需要到特别的框架,所以类型就默认地选择了“Pure Python”,名字就起成了“WebSpider”(我瞎命名的,就是觉得Spider比较帅气而已),然后“Create”如下图:新建一个Python文件,命名为Spider001,毕竟也是我的第一只小爬虫

2、嘛。OK,到目前为止,已经新建一个名字叫做Spider001的Python空白文件了。可以在项目等资源管理器中看到WebSpider项目下面,有一个Sider001.py的文件。我们接下来就对这个Sider001.py文件进行编辑和测试。2、第一爬先写代码,感受一下效果,找找成就感,然后再详细分析和思考。代码如下:import urllib.requesturl = http:/data = urllib.request.urlopen(url).read()data = data.decode(UTF-8)print(data)然后,Run,选择Spider001.py,运行结果如下:由上图可以见,运行正常,而且已经将百度的HTML代码获取到了(见运行窗口的第二行HTML代码)。百度心想,我也不知道倒了什么霉,你们爬虫测试的HelloWorld都喜欢拿我测试,无谓增加我压力。那我们再回头来详细看看刚才的代码:#首先引入urllib库的request子库import urllib.request#接着定义一个我们要爬取的变量叫url# 然后将我们要爬去的网址字符串值赋给url# 可怜的

3、百度。url = http:/# 定义一个data变量,用来获取爬过来的字符串# 下面是urllib的吧啦吧啦的用法,没什么好解释的。# 它就是这么用的,记住就好了。# 其中url是变量。data = urllib.request.urlopen(url).read()# 编码,改变编码。 decode方法。data = data.decode(UTF-8)# print打印出来结果。print(data)# 程序结束我们可以得出以下几点初学者的心得:l 用到一个urllib的库。Urllib库及其子库的用法,官方文档如下:https:/docs.python.org/3/library/urllib.html l 其获取url其内容的方法为:urllib.request.urlopen(url地址).read()l 将字符串本身使用decode(编码类型)的方法后,可以重新编码3、美女图片!美女图片!都说美女是推动社会发展的重要因素,对美女的追求,也是推动我们宅男技术水平的重要因素。当年在学校机房里用486电脑DOS环境下,冒着被机房老师抓住的生命危险偷偷看舒淇的图片,确实对我当年的

《林天宇用python3学习编写网络爬虫(之一)》由会员小**分享,可在线阅读,更多相关《林天宇用python3学习编写网络爬虫(之一)》请在金锄头文库上搜索。

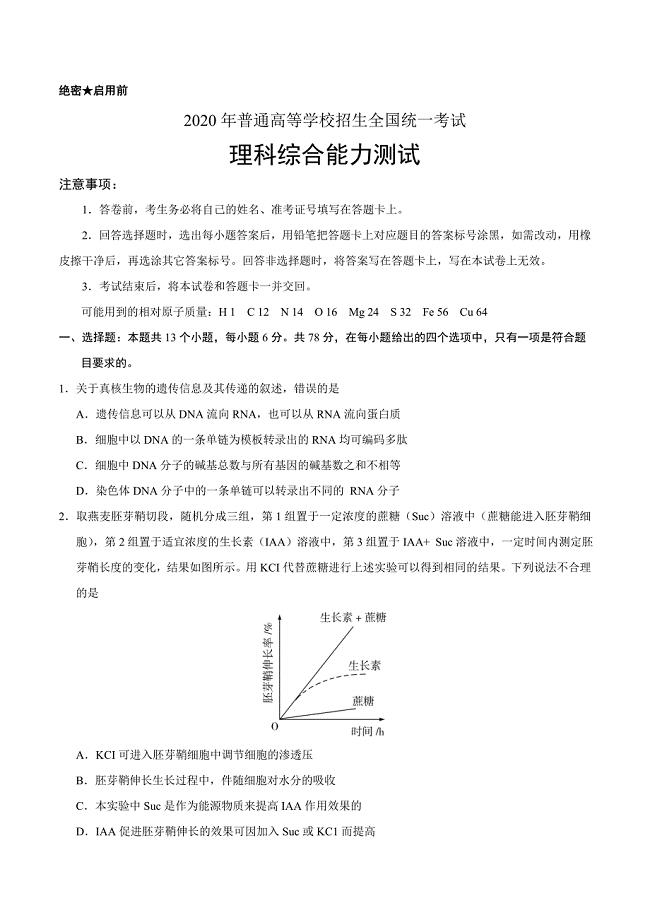

2020年高考真题——理科综合(全国卷Ⅲ)+Word版含答案

2021年绝味鸭脖策划书

2021年熟食店创业方案

2021年熟食店开店策划

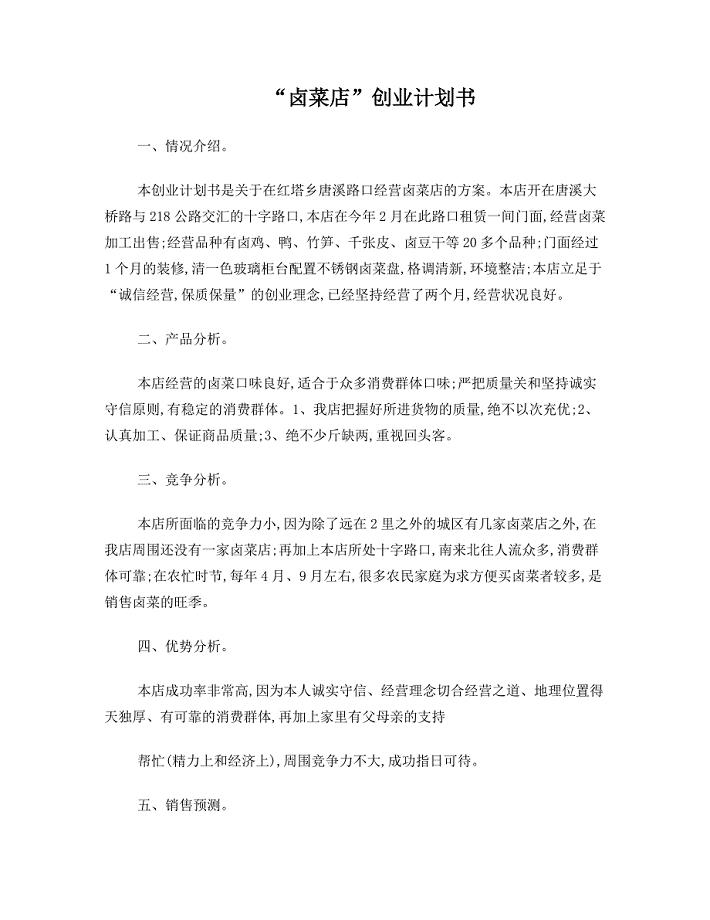

2021年卤菜店创业计划书

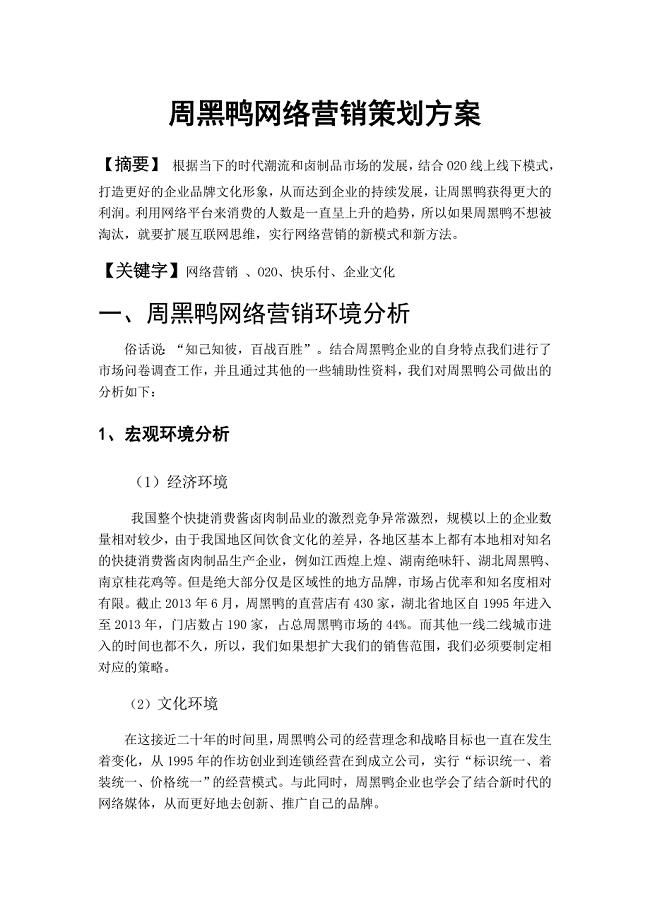

2021年周黑鸭网络营销策划方案

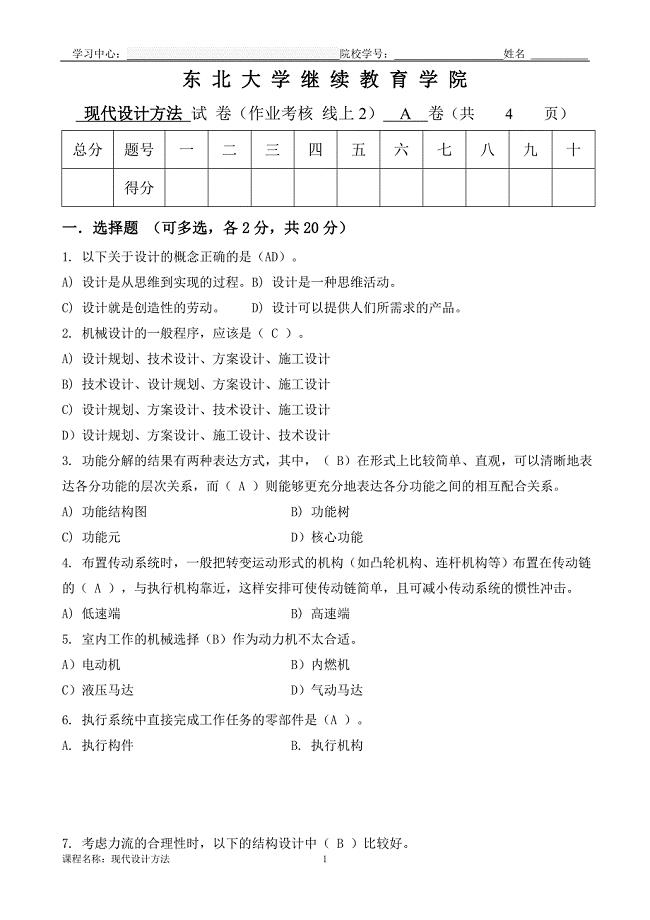

东大21年1月考试《现代设计方法》考核作业

谈我国行政管理效率的现状及其改观对策(论文)

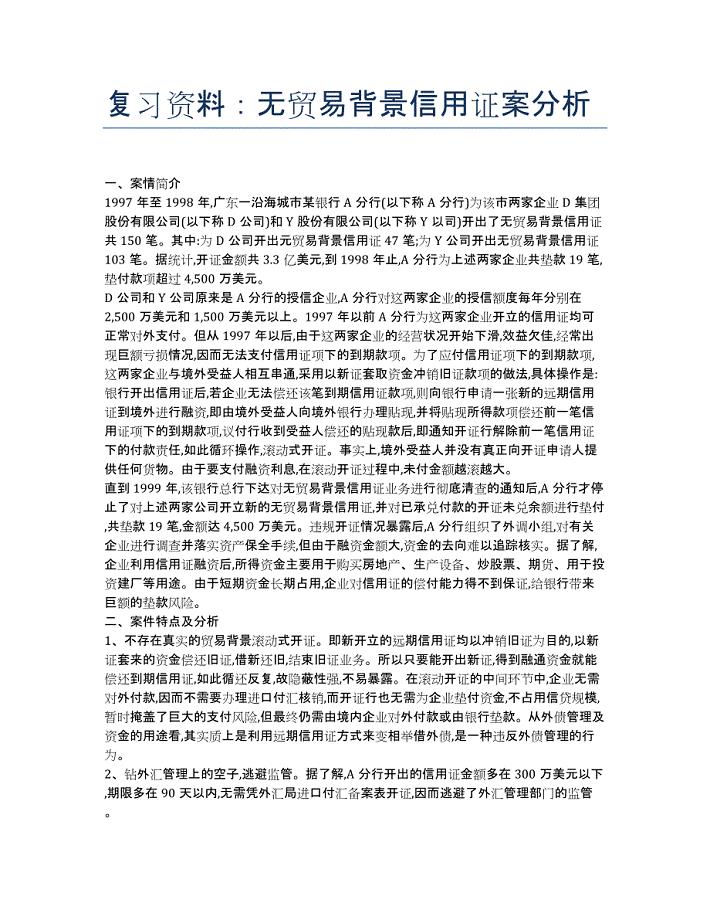

单证员考试-备考辅导-复习资料:无贸易背景信用证案分析.docx

土木工程毕业生答辩自述.docx

建筑学毕业后工作状态真实写照.doc

C#代码规范(湖南大学).doc

xx区食药监局2019年工作总结及2020年工作计划

2019年中医院药物维持治疗门诊工人先锋号先进事迹

2019年度xx乡镇林长制工作总结

2019年性艾科工作计划书

2019年人才服务局全国扶贫日活动开展情况总结

关于组工信息选题的几点思考

摘了穷帽子 有了新模样

2019年某集团公司基层党支部书记培训班心得体会

09.石油公司制度体系诊断及优化咨询项目

09.石油公司制度体系诊断及优化咨询项目

2024-04-08 33页

职工教育培训经费管理办法(规模生产制造业版)

职工教育培训经费管理办法(规模生产制造业版)

2024-04-08 10页

08.圆通银行战略咨询项目

08.圆通银行战略咨询项目

2024-04-08 25页

企业培训费管理实施暂行细则

企业培训费管理实施暂行细则

2024-04-08 12页

职工教育培训经费管理办法(适合中小企业)

职工教育培训经费管理办法(适合中小企业)

2024-04-08 10页

企业规章制度框架体系管理规定(2024修订版)

企业规章制度框架体系管理规定(2024修订版)

2024-04-08 21页

05.景宏集团全面管理提升咨询项目

05.景宏集团全面管理提升咨询项目

2024-04-08 40页

07.玉兔食品集团供应链咨询项目

07.玉兔食品集团供应链咨询项目

2024-04-08 34页

04.大华乳业业务战略咨询项目

04.大华乳业业务战略咨询项目

2024-04-08 28页

06.德邦公司精益生产管理咨询项目

06.德邦公司精益生产管理咨询项目

2024-04-08 28页